My particle-accelerator is bigger than yours

Från 1899 forskade Ernest Rutherford på olika sorters strålning. Han urskiljde alfa, beta och gammastrålar. 1909 utfördes Geiger-Marsden-experimentet, där man bestrålade guldfolie med alfastrålar (vilket senare visade sej vara identiska med heliumkärnor). Man bevisade i experiment 1911 att atomer hade kärnor och en del tomrum, vilket fick Rutherford att skapa sin atommodell 1913. 1919 lyckades han även påvisa protonen. 1920 förutsa han neutronen. När den påvisades 1932 så var atomens tre beståndsdelar kända.

Man nådde en experimentell gräns. Man behövde starkare grejjer. Gustav Ising fick en idé till en linjär partikelaccelerator 1924. Rolf Wideröe vidareutvecklade idén 1927. Han skapade resonansacceleratorn 1928. Hans arbete studerades av Ernest Lawrence i USA som vidareutvecklade conceptet till cycklotronen 1929. Max Steenbeck formulerade idén med cycklotroner medan han var student i Kiel 1922-27. Han sökte patent för Betatron 1934. Betatron accelererar betastrålar, som visar sej vara identiska med elektroner.

1931 byggdes en 23 cm stor cycklotron vid universitetet i Califonien som bevisade att konceptet fungerade.

Vad ska man med en partikelaccelerator till? Man kan studera subatomära partiklar under höga energier. Ju högre energier och ju större acceleratorer, desto mindre partiklar.

Donald Kerst utvecklade Betatron under 1940-talet vid universitetet i Iilinois. Cycklotron var den första sortens accelerator, följd av synchrotronen. De första som byggdes var alla cirkulära. Synchrotronen skapades 1945 av Ed MacMillan.

1952 utvecklade Ernest Courant m.fl ett sätt att fokusera, som bidrog till de storskaliga acceleratorerna, som idag är sinnebilden för "big science". 1954 beslutades att CERN skulle byggas. 1959 startades deras första accelerator, en proton-synchrotron. Den första partikelkollideraren byggdes 1961. Under 60-talet följde snabbt en explosion av nya partikellacceleratoranläggningar runt om hela världen.

Att de kända partiklarna skulle vara uppbyggda av kvarkar förutsades 1964. 1969 upptäckte "partons" när en protonstråle frontalkolliderade med en elektronstråle. Dessa "partons" har sedan identifierats som olika typer av kvarkar.

Det teoretiska resultatet av alla dessa anläggningar var "Standardmodellen" som var någorlunda utarbetat runt 1971. Forskarsamfundet accepterade kvarkmodellen i mitten av 70-talet i något som kallas "novemberrevolutionen".

Tack vare partikelacceleratorerna kunde man upptäcka och kategorisera subatomära partiklar som ofta hade förutsagts av symmetriprinciper.

Ett problem har länge varit att gravitationen har varit svår att införliva i standardmodellen och att man inte har hittat några gravitoner eller higgspartiklar. Gravitoner är i teorin praktiskt taget omöjliga att påvisa.

2009 blev Large Hadron Collider vid CERN den största acceleratorn i världen. 2011 stängde USA sin största accelerator.

Visst är forskarsamfundet internationellt och visst finns det andra anläggningar man kan använda, men det är ändå lite intressant eftersom det tidigare har varit lite grann av en prestigesak för USA att visa att man ligger i forskningsfronten. Anläggningen angav på dödsbädden att man kanske hade hittat en okänd partikel men det stämde inte.

I slutet av 2011 uppgav CERN att man kanske hade hittat higgs. Nu låter det inte riktigt så längre. Ett mer slutgiltigt besked väntas mot slutet av 2012. Kanske.

I teorin så kan kvantmekaniken och relativitetsteorin förenas i strängteori och m-teori, men dessa kan idag inte bevisas experimentellt. I teorin så skulle det behövas en accelerator lika stor som det kända universum för att man direkt skulle kunna påvisa strängarna i strängteorin.

Idag finns det över 30000 acceleratorer runt om i världen. De används till mycket annat än forskning. De används t.ex vid sjukhus och det finns idéer om att "små" acceleratorer kunde användas för att driva små thoriumreaktorer i mindre skala än dagens kärnanläggningar.

andra bloggar om

Positioneringstrilemma

1900-talet var ett antimetafysiskt sekel inom både analytisk och kontinental filosofi. Filosofin skulle inte fundera över materialism kontra idealism och sånt där. Det var vetenskapens område. Samtidigt så verkade inte minst fysiken att ställa en del rätt metafysiska frågor under 1900-talet. 1990-talets postmodernism verkar ha följts av en nymetafysisk rörelse nu i början av 2000-talet. Flera filosofer har närmat sej metafysiken igen och fyra av dem bildade för några år sen den kortlivade gruppen "spekulativ realism". Bland dessa så har jag funnit Graham Harman mest intressant (och Ian Hamilton Grant i andra hand) inte minst i relation till andra teorier.

Harmans OOO kan beskrivas på lite olika sätt. Han tycks föredra att peka på Husserl och Heidegger som föregångare men i minst en intervju så sa han istället att hans filosofi kan beskrivas som Whitehead plus Zubiri. Zubiri, som var elev till bl.a Husserl och Heidegger, förde bl.a den katolska teologin närmare den öst-ortodoxa. Whitehead å andra sidan är en mycket nyskapande och rätt inflytelserik filosof.

Harman tar de två viktigaste filosoferna från den kontinentala 1900-talsfilosofin och tolkar de på ett helt nytt sätt. Den kontinentala 1900-tals-filosofin utmärks bl.a av the linguistic turn och social konstruktivism. Liksom den analytiska 1900-tals-filosofin så är den kontinentala 1900-tals-filosofin antimetafysisk. Harman tar nu de två grundläggande filosoferna Husserl och Heidegger och tolkar de på ett förmodernt metafysiskt sätt. Samtidigt som han bekräftar vikten av de grundläggande kontinentala filosoferna så kritiserar han också mycket av deras efterföljare.

Det är lite lustigt att Harman som påstår sej ha läst i stort sett allt av Heidegger och som säger att Heidegger är en stor och viktig filosof, ändå säger att det allra mesta han har skrivit är rätt ointressant. Det är vid ett fåtal tillfällen som Heidegger enligt Harman är som mest metafysisk och intressant.

Heidegger själv tar ju uttryckligen avstånd från metafysik och säger att dess möjligheter är uttömda. Detta var något som hans favoritefterföljare Derrida tar fasta på. Harman tycker rätt illa om Derrida och dekonstruktion och annat som var i ropet när Harman skolade sej till filosof. Dock är dekonstruktion ett mångsidigt begrepp och man skulle t.ex kunna säga att Harman dekonstruerar Heidegger när han tolkar honom som metafysiker. Den formuleringen skulle Harman antagligen inte gilla.

Även Levi Bryant kan ju tänka sej att se vissa beröringspunkter mellan OOO och Derrida. Poststrukturalisterna är komplicerade filosofer som kan tolkas och misstolkas på många sätt.

Om poststrukturalisterna kan sägas vara "overminers", som upplöser objekten i deras relationer, så finns det även "underminers", som upplöser objekten i deras beståndsdelar. Här hittar vi Harmans dispyt med den samtida naturvetenskapen.

Harmans inställning verkar vara att även om filosofi och vetenskap kan influera och inspirera varandra så bör det ändå vara två ömsesidigt oberoende forskningstraditioner. Filosofin är t.ex ingen stödvetenskap till fysiken eller något sådant. Han har skrivit att han tror att OOO antagligen kommer att bli viktigast för humaniora och han försvarar även värdet av retorik och är skeptisk till matematikens starka ställning. Som filosof så har han filosofens rätt att spekulera om verklighetens sanna natur utan att kunna någon matematik alls.

Harman mellan Skylla och Karybdis: mellan postmodernism och scientism.

Analytisk och kontinental filosofi var under 1900-talet överrens om att naturvetenskapen som regel var bäst att lämna ifred, tillsammans med metafysiken. De hade små ambitioner att korrigera den på någon punkt. Ett avgörande ögonblick var t.ex debatten mellan Bergson och Einstein 1922 där Einstein allmänt ansågs sopa banan med Bergson. Dock skrev Einstein själv ett öppet brev till Bertrand Russell och klagade på att hans filosofi var för lite metafysisk.

Förutom Skylla och Karybdis så finns det dock även ett tredje hot som Harman måste undvika: han måste hålla avståndet mellan sin OOO och Whitehead. Han erkänner själv Whitehead som en viktig influens. Det är främst whiteheadianen Shaviro som har fört diskussioner direkt med Harman men även t.ex Deleuze, Stenglers och andra uppskattar Whitehead. Hans fans finns glest utspridda i många olika läger. I Sverige så har sociologen Karl Palmås intresserat sej. Shaviro har vid ett tillfälle skrivit att skillnaden mellan Whiteheads organic philosophy och OOO bara är estetisk, vilket Harman svarade på och förnekade. (Matematiker och fysiker vet att vitt skillda teorier eller metoder kan komma fram till identiska resultat.) Även om Harman har plockat vissa idéer från Whitehead så stämmer hans helhetstolkning av honom inte överrens med Shaviros, eller med min.

De kanske två viktigaste punkterna i OOO är för det första att man inte kan veta allt om ett objekt. Som regel så vet man ganska lite om ett objekt och även när man tror att man vet allt så skulle det fortfarande kunna överraska. Harman kallar detta för att objekt "drar sej tillbaka", ett något fenomenologiskt sätt att uttrycka saken, som kommer från Heidegger. Den andra punkten är att alla objekt är betraktare eller tar emot information från sin omgivning. Detta resonemang har Harman hämtat från Whitehead. För Whitehead så är det ingen artskillnad mellan medvetna varelser och omedvetna objekt utan bara en gradskillnad, en fråga om komplexitet. Liksom all perception förutsätter någon kausaliet så innebär all kausalitet någon form av "perception", eller "prehension" som Whitehead skriver. Andra viktiga punkter inom OOO är t.ex att objekt inte är reducerbara till sina beståndsdelar och inte heller till det sammanhang som de ingår i.

Harman tolkar Whitehead som en relationist och processfilosof. Detta är inte ovanliga uppfattningar, men jag tycker inte att det är fullständigt träffande. Whiteheads objekt uppstår visserligen ur universum men är inte reducerbara till resten av universum utan utgör ett unikt irreducibelt tillskott. Jag ska inte fördjupa mej i snåriga resonemang här men Whitehead är ingen ren relationist för mej. Vad gäller processfilosofin så är det visserligen sant för Whitehead att allt inom tiden är processer och att även objekt är en sorts processer, men Whitehead räknar även med objekt och sammanhang utanför tiden, som på sätt och vis är mer grundläggande.

Liksom Shaviro så är jag benägen att se likheter mellan OOO och organic philosophy. Detta att objekt drar sej tillbaka finns även hos Whitehead även om han inte gör någon stor poäng av det. Det är snarare trivialt att ingen kunskap om något någonsin kan vara fullständig.

Så mot Harman så kan man välja att se likheter med poststrukturalisterna och med Whitehead, så hur är det då med vetenskapen? Ray Brassier har vid något tillfälle kritiserat Harman för att Brassier tycker att Harman har avlägsnat sej för mycket från den samtida naturvetenskapliga världsbilden. Harmans svar på det var att Leibniz idag är mer vetenskapligt aktuell än någonsin förr, tre århundraden efter sin död.

Visst kan man urskilja vissa vaga likheter mellan OOO och vissa mat-nat fenomen som objekt-orienterad programmering, matematisk mereologi och systemteori, men flest beröringspunkter har jag hittat med en obskyr liten spekulation inom kvantfysikens mer filosofiska hörna, nämligen Relational Quantum Mechanics. Med tanke på detta så tycker jag inte alls att Harman har avlägsnat sej så långt från den samtida naturvetenskapliga världsbilden, oavsett vad han själv vill och tror.

Det är klart att det är ett långt avstånd mellan poststrukturalism och naturvetenskap, även om både Harman och Whitehead ur något perspektiv kan sägas befinna sej mellan dem. Harmans filosofi går i hög grad ut på att hävda att saker är distinkta från varandra och att även om saker kan vara "nära" varandra eller "likna" varandra så är de för den skull inte identiska. Som han själv skriver så är det ett filosofiskt val att betona skillnader framför likheter.

Make up your mind

"Besides, these analogies also give an interresting angle on "free will". It demands that not even you knows what youre thinking."

1.

Vanliga datorer är fundamentalt seriella i sitt problemlösande. De kan bara lösa ett problem åt gången och det måste vara ett lätt ett. Dock är de rätt snabba vilket ger illusionen av att de löser flera komplicerade problem samtidigt. Man har försökt att göra datorer mindre seriella genom att få flera processorer att samarbeta parallellt, parallel computing. Vissa framsteg har gjorts men det är svårt eftersom vanliga datorer är i grunden seriella.

Däremot så är kvantdatorer i grunden parallella. Och "i grunden" betyder här på en rent fysisk nivå. De allra minsta beståndsdelarna i en quantum computer kan arbeta på flera problem samtidigt. Detta innebär att kvantdatorer i teorin kan bli oerhört mycket snabbare än dagens allra snabbaste datorer. Detta är dock egentligen hela skillnaden; att de är snabbare. De kan inte lösa några problem som dagens datorer inte skulle kunna lösa i teorin, om de fick tillräckligt lång tid på sej.

Kvantdatorer kan dock bara utföra denna magi om man inte tittar på dom när dom gör det. Ett av de stora problemen är att undvika quantum decoherence. De minsta beståndsdelarna, qubits, får inte interagera med omgivningen förrän uträkningen är klar. Den kvantmekaniska superpositionen kan inte uppehållas särskilt länge, men uträkningen tar inte heller så lång tid.

2.

AI handlar om att upprepa naturens bedrift att skapa mänsklig intelligens. För det mesta så antas detta inte nödvändigtvis innebära något artificiellt medvetande, men åsikterna går isär. I första hand så handlar det om att skapa självreglerande informationssystem på åtminstone mänsklig nivå. Forskarna utforskar flera parallella angreppsmetoder, men det enda som verkar helt säkert är att det kommer att behövas mycket snabba datorer.

3.

Man kan notera att en mänsklig hjärna utför mycket parallel computing. De enskilda synapserna är egentligen inte så speciellt snabba, men det pågår väldigt mycket samtidigt. I likhet med kvantdatorer så kommer hjärnan bara fram till rätt svar med en viss sannolikhet. Hjärnan tycks ofta fungera enligt probabilistic computing. Kvantdatorer använder tydligen enbart probabilistiska algoritmer.

Människors kunskapande sker oftast i sociala nätverk. Kollektivet fungerar som en utvidgad hjärna. Det är möjligt att homo sapiens sapiens konkurrerade ut neandertalarna för att vi var mer sociala. I extremfall så kan dock vissa människor få svårt att bilda sej en egen uppfattning utan andra människor.

4.

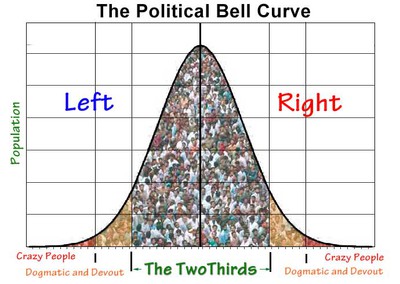

Under optimala förutsättningar så tycks kollektiv kunna vara intelligentare än någon individ. (Se historien längst ner här.) Detta fenomen har kallats wisdom of the crowds. Det är inte samma sak som collective intelligence.

Wisdom of the crowds kräver diversity of opinion, independence, decentralisation och aggregation. Värt att notera är att en metod för att skapa dessa förutsättningar starkt liknar en "demokratisk" metod.

Omvänt kan man säga att en kärnpunkt inom demokrati skulle kunna vara att destilera fram och ta till vara på the wisdom of the crowd. Detta är inte något av de vanliga argumenten för demokrati. Vanligtvis så brukar väl demokrati sägas vara ett sätt att avväpna konflikter i samhället, att balansera särintressen och att legitimera den rådande ordningen.

Möjligen kan man säga att en avsikt med en demokratisk process kan vara att förvandla en population till en artificiell intelligens eller en probabilistisk dator.

Dock misslyckas man med att uppnå wisdom of the crowds under följande förutsättningar; homogeneity, centralization, division, imitation och emotionality,

varav samtliga är mycket vanliga i samtida demokratiska processer.

För att närma sej idealet med wisdom of the crowds, kanske samma sak som Rousseau kallade "folkviljan", så måste man t.ex sluta med opinionsundersökningar, tvinga debattörer att vara ärliga och sakliga, uppmuntra parallella informationskällor, hålla hårt på valhemligheten och utvidga rötsträtten (eftersom den enskilde röstarens kompetens inte är så central) m.m.

Om man ser på en röstande befolkning som en probabilistisk, parallellprocessande dator, analogt med en kvantdator eller en hjärna, så är resultatet bl.a beroende av goda indata och att processen inte störs. Lustigt nog så kan man inte fråga de röstande vad de tänker utan att störa processen, analogt med både en hjärna och en kvantdator.

Nån som har lust att crowdsourca dom här uppslagen? Dvs stjäla idéerna?